Bien qu'il existe des extensions pour améliorer le référencement d'un site, elles se limitent en général à ajouter aux CMS des champs supplémentaires pour les balises SEO, mais ne prennent pas en compte le rendu final des pages qui peut être différent une fois le code HTML assemblé et envoyé au navigateur. Screaming Frog est un logiciel qui permet d'indexer (crawler) un site à la manière d'un spider de moteur de recherche en récoltant des informations techniques importantes sur les pages visitées comme l'état des liens, des images, des titres SEO, des metas description, de la vitesse de chargement des pages, des en-têtes http, voire l'orthographe ou toutes chaînes de caractère particulières.

Son principal intérêt est de fournir rapidement une vue complète d'un site ou de ses concurrents. Sur un site comportant un grand nombre de pages, l'automatisation permet de corriger des problèmes qui ne seraient peut-être pas apparus lors d'une vérification manuelle et donc d'optimiser la qualité globale du site et de son référencement. Cette application s'installe sur un ordinateur Mac, Linux ou PC et bénéficie d'un support rapide en cas de problème. Contrairement à d'autres services SEO, le prix est abordable et il existe une version gratuite limitée à 500 URLs pour se faire une idée des capacités ou de l'utilité du logiciel avant l'achat.

Configuration du logiciel

Avant de lancer le crawl d'un site qui peut prendre du temps en fonction du nombre de pages à indexer, il est nécessaire de faire quelques réglages préalables:

- Activer le mode sombre (Dark mode) est bien pratique, lorsqu'on consulte de nombreux tableaux de données (dans configuration > interface utilisateur).

- Mettre le stockage en mode base de données pour éviter les problèmes de manque de mémoire vive.

- Paramétrer la vitesse du spider.

- Connecter les API de Google Analytics, Google search console, Google Page Speed ou des autres logiciels SEO supportés.

- Connecter les API d'IA comme Gemini ou OpenAI.

Crawler une page web, une section d'un site ou sa totalité

- Il est possible d'indiquer l'adresse de son site web, d'un sous-domaine ou l'URL d'une page précise, ce qui est très pratique pour contrôler son travail après une modification.

- Sur les gros sites, limiter le crawl à une langue, notamment si vous vérifiez l'orthographe, ou en supprimant certains dossier comme celui des images.

- A contrario, il est possible de définir une liste d'URLs à crawler en passant dans le mode Liste. Les URLs peuvent être entrées manuellement ou sous forme de sitemap xml.

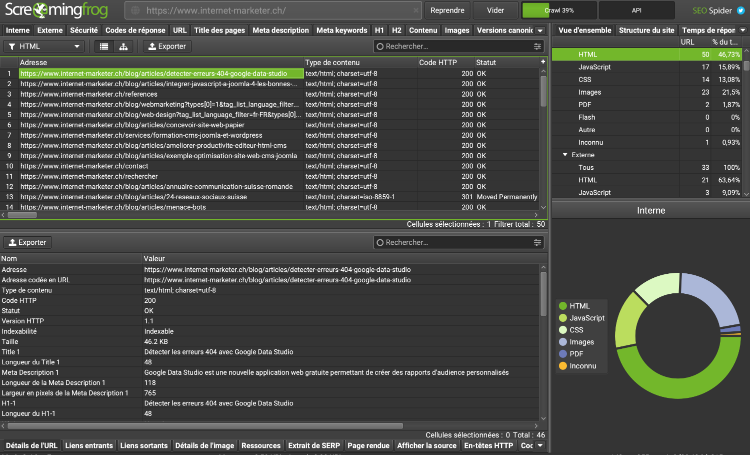

Comment fonctionne l'interface

La liste des liens est affichée progressivement dans le quadrant en haut à gauche dès le lancement de l'indexation. Il est possible de filtrer certains types de liens avec un menu déroulant (exemple: HTML, images, scripts, css, etc.). Cliquer sur un lien permet d'en savoir plus dans le quadrant du bas. Les onglets des deux quadrants permettent de croiser les données de multiples façons. Par exemple, pour vérifier les liens sortants, on cliquera sur l'onglet Externe en haut et Liens entrants en bas pour définir la page d'origine. Le quadrant de droite présente un résumé de l'ensemble des résultats et là aussi il est possible de cliquer sur un type de données pour afficher les liens correspondants, par exemple tous les fichiers Javascript. Une fonction intéressante présente dans ce quadrant est un récapitulatif des problèmes du site. Cliquer sur un problème, par exemple "Titre des pages en doublon" affichera l'ensemble des pages concernées dans le quadrant de gauche.

De plus, chaque lien parcouru par le spider peut déclencher un menu contextuel pour effectuer des opérations supplémentaires, par exemple vérifier la présence du lien dans l'index de Google ou de son cache, obtenir des backlinks en utilisant une API commerciale, valider la conformité W3C du lien, sa vitesse d'affichage, copier le lien ou le supprimer de la liste s'il a été corrigé.

C'est très efficace. Il est possible d'exporter les résultats au format csv et de nombreux rapports sont pré-configurés.

La suite de l'article présente quelques exemples d'utilisation de ce logiciel.

Vérifier les liens du site

Les liens sont à la base du fonctionnement du web et conserver leur intégrité pendant la durée de vie du site est cruciale à la fois pour le référencement dans les moteurs de recherche, mais aussi pour offrir une bonne expérience utilisateur à vos visiteurs et pour économiser l'utilisation des ressources de votre serveur.

- Liens internes et externes cassés.

- Pages avec un trop faible nombre de liens entrants (inlinks).

- Liens non sécurisés (sans le protocole https).

- Liens vers des scripts externes.

- Liens non canoniques (non uniques).

- Liens qui continuent à rediriger en direction du serveur de développement.

- Fragments cassés, par exemple dans les liens internes sur une même page.

- État des redirections et code de redirection. Vérifier que les redirections fonctionnent correctement ou transformer les liens avec redirection en liens directs, ce qui est très utile après la migration d'un site.

- Liens bloqués par le fichier robots.txt.

- Liens bloqués par des directives comme nofollow ou noindex.

- Paramètres dans l'URL ou présence de caractères spéciaux.

Vérifier les pages HTML

- Vérifier la présence ou non de titres avec les balises h1 et h2, leur nombre et les doublons.

- Vérifier la taille des textes, leur similarité et les contenus en double (avec des URLs différentes).

- Vérifier l'orthographe. Attention de configurer préalablement la vérification de l'orthographe et de la grammaire et de limiter le scan à une langue du site. Les erreurs sont affichées dans l'onglet Contenu et dans le quadrant du bas en sélectionnant Orthographe et grammaire.

- Vérifier la conformité du site aux règles d'accessibilité standards.

- Rechercher des shortcodes non utilisés.

- Vérifier l'intégrité des balises head et body grâce au nouvel onglet Validation.

- Rechercher des extraits de texte ou de code HTML à modifier ou supprimer.

- Extraire n'importe quel élément de la page HTML à l'aide du langage XPath.

- Détecter les différences entre un site en production et un site en développement.

- Vérifier le temps de réponse de la page et de ses assets.

Vérifier les balises SEO

Les balises SEO ne sont pas visibles dans le contenu du site, Screaming Frog permet d'en faire une liste facile à contrôler d'un coup d'oeil:

- Vérifier les titres SEO des pages HTML: texte, longueur et présence de doublons.

- Vérifier les balises meta description: texte, longueur et présence de doublons.

- Les balises meta keywords ne sont plus utilisées par Google et même abandonnées dans certains CMS, mais il peut toujours être utile de vérifier leur présence sur certains sites.

- Demander à une IA connectée d'améliorer le contenu des balises SEO.

- Les balises meta robots qui peuvent bloquer des pages.

- Vérifier et valider les données structurées aux formats micro-données ou json+LD.

- Visualiser l'apparence de chaque lien dans les résultats des moteurs de recherche (snippet).

Vérifier l'intégrité des médias (images, vidéos)

Il est possible d'afficher les URLs des images qui génèrent un code http 404 ou 403 (images cassées ou interdites) de la façon suivante:

- cliquez sur l'onglet Codes de réponse, puis créer le filtre de recherche suivant:

Adresse Contient '.png' Ou Adresse Contient '.jpg' Ou Adresse Contient '.svg' - dans le menu déroulant, choisir Erreur 4xx.

- dans le quadrant du bas, choisir Liens entrants pour trouver l'origine de l'image cassée.

Le logiciel contrôle aussi la taille des images, la présence des attributs width, height, alt et la longueur du texte de l'attribut alt. Il est possible d'exporter sous forme de fichier Excel la totalité des liens des images avec les textes de l'attribut alt, afin de pouvoir les vérifier plus facilement.

Est-ce que vous vous êtes déjà demandé, si une image était toujours utilisée sur votre site ? Une simple recherche du nom de fichier dans la liste des liens internes vous le confirmera. C'est non seulement vrai pour les images, mais aussi pour tous fichiers CSS, Javascript, PDF, etc.

Vérifier les données techniques

Dans la partie configuration > Spider > Extraction, you pouvez configurer l'extraction de données techniques variées, parmi les plus utiles pour moi:

- Cookies.

- En-tête HTTP

- Dernière date de modification.

- Taille de la page.

Examiner la structure du site

Il est possible de visualiser le maillage des liens d'un site sous forme d'arborescence ou de nodes avec un système qui pondère leurs poids respectifs. Cela permet de se rendre compte facilement si certaines parties du site sont isolées de la structure principale et si la navigation est peu efficace. Une fonction d'analyse permet d'attribuer un "link score" à chaque lien un peu à l'image du "Pagerank" de Google et donc de déterminer les pages avec un maillage de liens fort ou faible.

Indexation des pages dans les moteurs de recherche

- Le logiciel offre de nombreux réglages pour créer un sitemap xml du site pour les moteurs de recherche, ce qui est intéressant pour un site à l'arborescence statique. L'avantage est bien entendu de fournir au moteur de recherche un sitemap vérifié et sans erreurs.

- En connectant SF à l'API de Google search console, il est possible de contrôler quelles pages du site ne sont pas indexées par Google et, pour chaque page, la date du dernier crawl de Google Bot.

Examiner les mots clés

On peut obtenir une liste de mots clés d'un site concurrent ou du sien à partir des diverses informations fournies par Screaming Frog comme le titre SEO, meta description, les balises h1, h2 ou d'autres balises grâce à l'extraction personnalisée.

Sécurité

L'onglet Sécurité permet de lister les en-têtes http de sécurité manquantes comme hsts ou x-content-type-options. Une autre fonction très utile est de pouvoir déterminer les liens restants qui n'utilisent pas le protocole sécurisé https.

Performances

Il est possible de connecter SF à la clé API gratuite de Google Page Speed ou d'une version intégrée localement de Google Lighthouse. Il devient alors possible de créer un rapport complet des core web vitals de toutes les pages du site et de les filtrer en fonction des améliorations suggérées, par exemple toutes les pages où il faut dimensionner correctement les images.

La dernière version de Screaming Frog peut contrôler l'empreinte carbone de chaque page du site. N'oubliez pas de définir dans la configuration, si l'hébergeur dispose d'une infrastructure conforme aux normes environnementales.

Comparaison entre deux crawls

Le mode Comparer de Screaming Frog permet de déterminer ce qui a changé entre deux crawls.

Screaming Frog ne se présente pas comme une solution miracle pour bien référencer son site. Ce logiciel propose plutôt une palette d'outils avec un grand nombre de paramètres pour mieux analyser les sites web et optimiser chaque détail technique dans le cadre d'un travail de qualité professionnelle. De bonnes connaissances techniques sont donc nécessaires pour en tirer parti et pour effectuer toutes les modifications sur votre site web. Vous pouvez cliquer sur le lien ci-dessous pour en savoir plus:

Source: Documentation de Screaming Frog